Voici des articles exclusifs que je n’avais publié que sur Linkedin (je crois, peut-être y a-t-il une ou deux exceptions…). Cela concerne pas mal de sujets divers mais je vous livre tout en vrac !

Bon, c’est tout de même par ordre chronologique, si ça peut aider…

Mes chroniques publiées sur Linkedin

La simulation, technique d’avenir, ô combien !

Publiée le 2 juin 2019 sur Linkedin

L’anticipation, sous-domaine de la science-fiction, joue son rôle quand elle permet de prévoir ce qui va nous arriver dans le futur. Dans le cas qui nous occupe ici, la question est centrée sur les applications de la simulation et leurs conséquences. Tout d’abord, il n’y a guère de doute que la simulation sera mise en œuvre.

Déjà, du côté scientifique, il y a beaucoup de justifications à le faire : pour modéliser les phénomènes naturels (tels que le climat et ainsi être en mesure de mieux prévoir son évolution ainsi que la météo à court terme) mais aussi et surtout pour modéliser les phénomènes sociaux (avec la nécessité de simuler les personnes jusqu’au niveau individuel le plus fin).

Aujourd’hui, de nombreux phénomènes sociaux sont considérés comme chaotiques, principalement par ignorance. Une fois simulés correctement, on pourra les étudier sous tous les angles et comprendre enfin la dynamique de chacun (si vous voulez optimiser l’évacuation d’un grand bâtiment, il vous faut connaitre à l’avance le comportement de la foule lors d’un mouvement de panique…).

Mais le domaine scientifique « pur » va être un champ d’application minoritaire de la simulation (contrairement à ce qui sera mis en avant pour justifier de la mettre en œuvre). Le domaine économique sera bien plus prolifique dans son utilisation des « simulis » !

Le domaine de la publicité, par exemple, sera un grand consommateur de situations simulées afin d’optimiser le message, le plan média, la fréquence de diffusion et ainsi de suite. On imagine bien que les politiciens, comme les publicitaires, vont également se jeter sur cet outil pour ajuster leurs discours en fonction de leurs cibles.

Tout cela parait évident une fois exposé correctement. Mais c’est dans le domaine de la « distraction » que le secteur économique va le plus avoir recours à la simulation, hé oui. En effet, regardez le succès actuel des différentes déclinaisons de ce qu’on appelle encore « les jeux vidéo » (voir à http://fr.wikipedia.org/wiki/Jeu_vidéo). Il suffit de regarder les chiffres pour se convaincre de l’importance croissante de ce secteur : l’industrie vidéoludique (c’est comme ça qu’on l’appelle selon Wikipédia…) génère actuellement un revenu plus important que celui du cinéma et ceci depuis 1997. En 2007, le revenu global approchait les 40 milliards de dollars. En 2012, le chiffre d’affaires mondial de l’industrie atteint 60 milliards de dollars selon le SNJV (Syndicat National du Jeu Vidéo). L’industrie vidéoludique serait ainsi la première industrie culturelle dans le monde. Le jeu le plus coûteux de l’histoire (fin 2013), GTA V, a coûté 270 millions de dollars (moitié production, moitié marketing) soit l’ordre de grandeur d’un blockbuster hollywoodien.

Donc, on a un moyen médiocre (pour dire le mieux) de se projeter dans un univers plus ou moins bien simulé (là encore, on reste gentil) et ça marche du tonnerre : des millions de gens (et pas que des jeunes) y passent un temps de plus en plus important tout en y dépensant une somme d’argent pas ridicule. Que se passera-t-il le jour où on pourra proposer une alternative autrement convaincante ?

Oui, vous m’avez bien compris, j’en reviens encore à la simulation, la vraie. Le jour où on pourra vous proposer une plongée en immersion totale dans les univers simulés (spécialisés au début, généralistes ensuite), vous allez voir que l’offre va faire recette immédiatement (et ça sera le cas de le dire : les succès financiers des jeux vidéo actuels paraitront bien pâles en comparaison !). Les gens vont se ruer vers ce nouveau « loisir » et les cas d’addiction vont se multiplier jusqu’à atteindre un seuil alarmant : le nombre d’individus qui vont préférer vivre une vie « plus ou moins scriptée » (en fonction de leurs préférences) dans les univers simulés va être surprenant. Tout du moins, ça sera surprenant à nos yeux d’aujourd’hui alors que ça paraitra banal quand ça sera possible. De la même façon qu’un honnête homme du XIXe siècle serait étonné de voir quelle est l’étendue actuelle de la consommation des substances addictives (y compris le sucre, les cigarettes, les médicaments, en plus des substances illégales comme les drogues dures).

Il n’est donc pas impossible (pour ne pas dire qu’il est probable) que l’usage des simulis soit le prochain grand problème de société à l’avenir. Voire même fera naître une autre catégorie de population : ceux qui vivent principalement en immersion (dans les simulis donc) et très peu (voire le moins possible) en dehors.

Bien entendu, cette situation ne va pas arriver du jour au lendemain. Tout d’abord, la mise au point de la « simulation totale » va prendre un certain temps (mais sans doute sera-t-elle là avant la singularité technologique qui reste un horizon hypothétique alors que la simulation totale est une perspective quasi certaine). Ensuite, les techniques d’immersion resteront compliquées et coûteuses pendant une période plus ou moins longue et, clairement, le transfert synaptique (si on continue à l’appeler ainsi) ne sera pas à la disposition de tout un chacun avant des décennies. Cependant, cela va finir par arriver et quand ça sera là, les digues vont céder et les masses vont s’y précipiter. Qui restera-t-il « à la surface » ?

Les deux extrémités, comme d’habitude : les plus pauvres qui n’auront pas les moyens de se payer une immersion (même brève) et les plus riches qui préféreront regarder tout cela de haut, tout en tirant les ficelles pour les plus malins d’entre eux.

L’avènement de la simulation aura quelques conséquences inattendues : disparation de la prostitution (tout du moins dans les pays riches, elle sera toujours effective dans les pays pauvres) et disparition des compétitions sportives. Ces disparitions seront limitées à leurs expressions physiques dans le monde « réel », car, bien sûr, compétitions et prostitution seront plus que jamais à la mode dans les simulis…

Pas besoin d’expliquer pourquoi la prostitution va être florissante dans les mondes virtuels, penchons-nous sur les raisons concernant les compétitions : facilités d’organisation, plus grande liberté des règles, diffusion « télévisée » à l’identique, réduction du danger et de ses conséquences, etc.

Encore que, pour ce dernier point, rien n’est moins sûr. On ignore encore (et pour cause !) quels seront les effets secondaires (ou encore, les effets réels, tout simplement) que pourraient avoir une blessure ou un traumatisme sur mon corps réel lorsque ces dommages arriveront à mon « avatar » en immersion… Peut-on vraiment séparer le corps de l’esprit ?

Voilà le type de « découvertes » que nous allons faire avec l’avènement de la simulation totale. Accrochez-vous, ça va secouer, car, comme disent les Anglais « there is always a surprise! » (il y a toujours une surprise).

PS) on constate que les simulis commencent à être mis en place par les industriels (à travers ce qu’on commence à appeler les “jumeaux numériques”). Les motoristes de l’aviation civile simulent le fonctionnement des moteurs équipant les flottes des compagnies aériennes en les alimentant avec les données réelles venant des vrais moteurs qui volent tous les jours.

Le but est de prévenir les pannes, d’anticiper les opérations de maintenance. Mais il est clair que, à l’avenir, ces simulations très techniques auront tout intérêt à être reliées à d’autres dans les domaines voisins : la météo afin de pouvoir y ajouter les données d’environnement et ainsi de suite. Une fois qu’on a cette image en tête, il est assez facile de se projeter la suite.

Et ce n’est que le début…

La technostructure est-elle en train de devenir autiste ?

Publiée le 18 septembre 2019 sur Linkedin

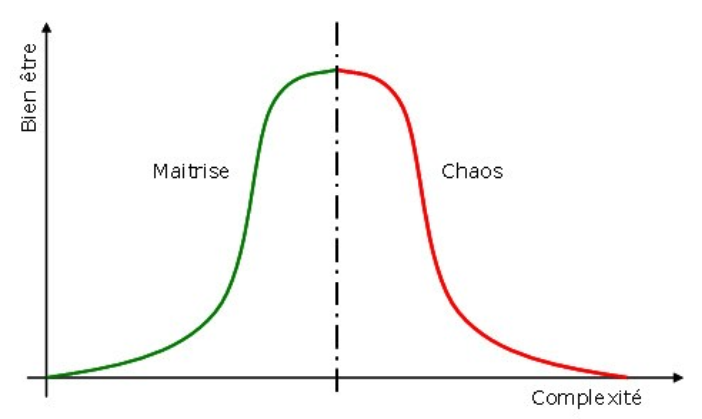

C’est la question qu’on peut se poser face au fossé qui est en train de se creuser entre les “gens normaux” et toutes les infrastructures dans lesquelles nous vivons et évoluons que j’ai pris l’habitude d’appeler la technostructure. En effet, on constate de plus en plus que le niveau de complexité augmente, que les réglementations s’accumulent, deviennent de plus en plus restrictive et qu’il est de plus en plus compliqué de les respecter, de les suivre ou même de les comprendre. En plus de cela, la numérisation croissante de nos interactions avec ses interlocuteurs (organisations ou sociétés), au lieu d’apporter les bénéfices espérés et promis produit de plus en plus de frustrations bien légitimes. En effet, on est de plus en plus souvent face à un mur, confrontés à des interfaces qui n’ont pas été pensées et qui n’ont pas été testé avec des “gens normaux” et qui vous imposent leur logique si tant est qu’elle soit compréhensible.

Et c’est moi qui dis cela !

Moi qui utilise des ordinateurs tous les jours depuis 1983… Moi qui suis à l’aise avec les systèmes techniques les plus divers, mais qui n’arrive plus à supporter l’absurde bureaucratie dans laquelle s’enfonce notre société.

Ce décalage de plus en plus fréquent et de plus en plus profond doit nous interroger. Jusqu’au cela va-t-il aller avant qu’un vrai craquement se produise ?

Va-t-on assister à un autre mouvement populaire de type “gilet jaune”, mais qui, cette fois, ne viendra pas des pauvres qui ne supportent plus d’être écrasés, mais des gens aisés qui ne supportent plus d’être oppressés par cette technostructure qui devient de plus en plus autiste.

À l’heure où l’on parle de plus en plus de relation client, sur le terrain, la situation est blême : le client, justement, a de plus en plus l’impression de ne plus être entendu, voire même de plus être respecté. Ce décalage ne peut plus durer, il va forcément déboucher sur quelque chose et j’ai bien peur que ce quelque chose ne soit pas souhaitable…

Pourquoi prédire un “hiver de l’IA” est contre-intuitif ?

Publiée le 7 janvier 2020.

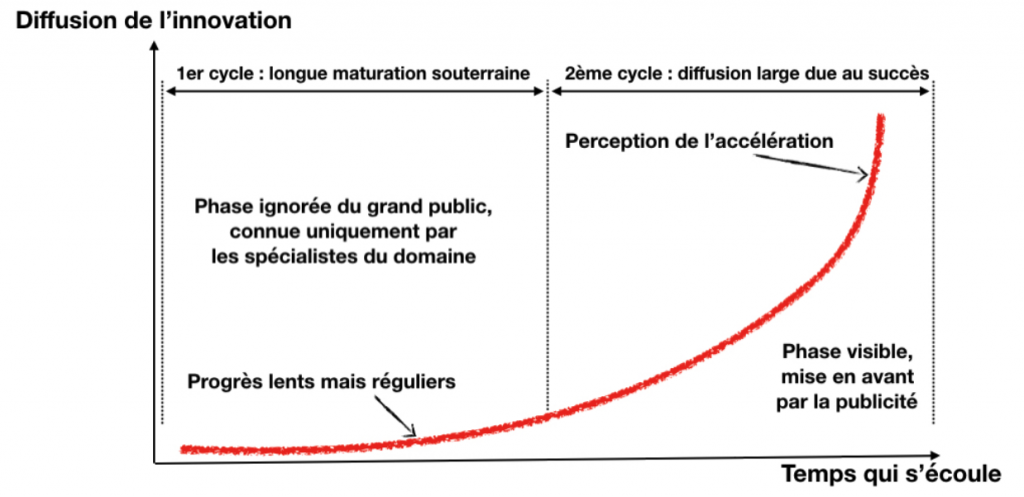

Dans certains de mes écrits précédents, je reviens souvent sur une idée forte : l’IA, actuellement formidablement à la mode, va bientôt entrer dans une période moins florissante, un nouvel “hiver de l’IA” comme cette discipline en a déjà connu deux dans son passé. Pourtant, bien que les éléments qui indiquent ce prochain effondrement s’accumulent, le battage médiatique ne faiblit pas et continue à résonner positivement avec l’assentiment (aveugle ?) de la grande majorité des “analystes” de la tech. Pourquoi ?

Pour comprendre les forces qui sont à l’œuvre ici, je vous propose de nous pencher sur les mécanismes mentaux qui entretiennent cette croyance (l’IA, c’est l’avenir) en dépit des signaux qui indiquent le contraire.

Psychologie des foules

Prédire l’hiver de l’IA, c’est comme prédire un krach boursier : il est impossible d’indiquer avec précision quand cela se produira. Cependant, comme avant un krach boursier, on peut déjà observer des signes de l’effondrement imminent. Actuellement le “récit IA” trouve encore une résonance si forte qu’il est plus facile (pour le grand public) d’ignorer ces signaux et de continuer à croire cette belle histoire.

Pour comprendre la force du “récit IA”, il faut sortir du domaine de la tech pour passer dans le domaine de la psychologie sociale, de la psychologie des foules. Chaque nouveau convaincu renforce la conviction de l’ensemble avec des arguments du genre “un millions de personnes ne peuvent pas avoir tort, ne peuvent pas penser la même chose en même temps et se tromper” alors qu’on a des exemples par le passé qui montrent que le volume ne fait rien à l’affaire et qu’on peut avoir des foules qui ont des convictions (y compris très fortes comme dans le domaine religieux) qui ne reposent hélas sur rien. Dans le domaine de l’IA, il faut comprendre que chaque démonstration médiatique vient renforcer les autres. On est donc face à un effet cumulatif qui finit par ancrer une conviction en profondeur dans chacun de nous, on finit par s’habituer à “l’évidence” de telle ou telle affirmation, de telle ou telle hypothèse. Au bout d’un moment, elle n’est plus considérée comme une hypothèse, mais ça devient un fait (ça ne l’est pas), au moins dans la tête des gens. C’est ce mécanisme qui est à l’œuvre continuellement avec le battage médiatique autour de l’IA (et c’est pareil pour les autres modes).

Renforcement positif, forcément

Les membres du système médiatique vont, consciemment ou inconsciemment, appliquer un filtre de “renforcement” dans le choix des nouvelles qu’ils publient. Donc, dans un premier temps, ils vont plutôt publier des articles avec des éléments qui vont dans le sens d’une confirmation du phénomène en cours. Il faudrait le tarissement de cette source (celle qui confirme le phénomène) puis l’apparition d’une autre source (qui elle infirmerait la chose) qui irait dans l’autre sens (finalement, le phénomène “à la mode” n’est que vent, ça marche, etc.) et seulement si le flot de la seconde source se met à dépasser la première, on verrait le ton s’inverser. Et si on en arrive là, l’emballement médiatique reprend, mais dans l’autre sens.

Retournement de tendance, généralisée

Tout d’un coup, tous ces commentateurs qui disaient et répétaient “l’IA c’est l’avenir et ça va tout changer” vont se mettre à dire à l’unisson “finalement, c’est pas pour tout de suite, c’est limité, on a trop rêvé, etc.”. C’est un cycle qui se reproduit à l’identique depuis des décennies encore et encore. On a eu de nombreuses modes qui ont permis de l’illustrer (ce n’est d’ailleurs pas limité au domaine technique, on voit le même “cycle du hype” partout, y compris dans les domaines économiques et politiques). Ce n’est pas pour rien qu’en matière d’IA on parle de “printemps” et “d’hiver” parce que ça s’est déjà produit et l’on sait que ça va se produire à nouveau.

Une bulle médiatique, encore et toujours

Actuellement, nous avons tous les signes qui permettent d’identifier un prochain “hiver”, c’est-à-dire qu’on sait qu’on a accumulé tous les indices qui désignent une bulle, une bulle médiatique autour de l’IA qui se caractérise par “assez peu de signaux et beaucoup de bruits” (d’ailleurs, toutes les bulles médiatiques sont toujours basées sur un rapport signal/bruit complètement disproportionné !). La différence flagrante entre l’ampleur de l’écho donné aux réalisations spectaculaires (mais peu nombreuses) et le silence sur les réalisations ordinaires indiquent que ces dernières sont bien trop rares pour que la situation puisse être considérée comme “normale”. Donc, une mise en scène grandiose d’un côté et le désert de l’autre. On retrouve ce décalage aussi bien avec Watson d’IBM qu’avec Deepmind de Google. Dans ce dernier exemple, on va parler encore et toujours de sa formidable réussite dans le domaine du jeu vidéo et du jeu de Go, mais on va taire le fait que Deepmind n’arrive pas à trouver des débouchés pour ses logiciels en dehors de la “galaxie Google”. Pourquoi ce biais narratif ?

Eh bien parce que c’est plus facile et mieux reçu par la cible habituelle de ressasser quelque chose de connu que de proposer une vraie analyse, une analyse critique de la situation. Donc, on ne le fait pas sauf quand l’époque et l’atmosphère sont devenues favorables à un “AI bashing” qui, très vite, se généralise (emballement médiatique de fin de cycle). Ce décalage entre le grandiose de ce qui est mis en avant (AlphaZero et le jeu de Go) et le désert des réalisations plus modestes, mais concrètes peut être expliqué par le principe des retours décroissants qui est presque un effet de “miroir inversé” avec l’enflure médiatique qui elle va croissant.

Les retours décroissants

On sait bien que toute nouvelle application produit ses plus grands résultats au début de sa mise en œuvre. Et ensuite, il faut de plus en plus d’efforts et de moyens pour récolter de moins en moins de résultats (du moins en proportion des efforts investis). C’est ça le principe des “retours décroissants” qui est le mieux et le plus facilement illustré par l’exemple de la mine. Au début, l’extraction du minerai, quand on tombe sur le filon, pas très loin de la surface, est relativement facile : en gros, il n’y a qu’à se baisser pour ramasser les pépites. Donc, résumons : peu d’efforts, des résultats spectaculaires, une très grosse rentabilité. Encouragés par ces débuts formidables, vous allez être prompts à investir pour augmenter les volumes : on commence à creuser plus loin, plus profond, à étayer les galeries, à poser des rails pour les wagonnets et à installer des pompes pour garder tout cela au sec. De plus en plus d’efforts pour une extraction qui, certes, croît en volume, mais à un prix évidemment plus élevé (y compris sur le plan proportionnel) qu’au début… On retrouve la même analogie partout : la percée est spectaculairement rentable, la suite beaucoup moins.

Et c’est la même chose vis-à-vis de l’IA : les premières percées qui produisent les résultats spectaculaires (forcément, on n’avait rien vu de tel auparavant) sont les plus faciles. Après, les raffinements et la généralisation (le test ultime) sont de plus en plus difficiles et délicats. On en a un exemple criant, en ce moment même, avec les déboires des voitures autonomes. Au tout début, voir circuler des voitures qui se dirigent sans qu’on se préoccupe de tenir le volant, c’était sensationnel !

Mais après, pour sortir des sentiers battus des expérimentations limitées en territoires connus et proposer des voitures autonomes de niveau 5 partout et tout le temps, quelque soit la météo, le revêtement et la circulation aux alentours, avec tous les types d’obstacles et d’aléas, c’est autre chose… Et c’est bien pour cela que la vraie voiture autonome se fait attendre et se fera attendre pendant encore bien des années. Même si c’est contre-intuitif, c’est la vérité.

En fait, les choses les plus difficiles en IA comme pour la robotique sont les tâches perceptuelles et motrices les plus élémentaires, comme le résume le paradoxe de Moravec :

“il est relativement facile de faire en sorte que les ordinateurs présentent des performances de niveau adulte lors de tests d’intelligence ou de jouer aux dames, mais il s’avère difficile ou impossible de leur donner les compétences d’un enfant d’un an en ce qui concerne la perception et la mobilité “

Hans Moravec a déclaré son paradoxe pour la première fois en 1988. Et comme c’était il y a de nombreuses années, du coup, on peut penser que cela n’est plus applicable. Mais plus de trente ans se sont écoulés depuis que Moravec a fait son observation, les ordinateurs sont devenus des milliards de fois plus rapides, les caméras sont devenues des millions de fois plus précises, et… rien n’a changé. Passées les démonstrations faciles, l’IA et la robotique peinent à franchir les obstacles du monde réel, car il leur manque notre “conscience de l’environnement” que nous avons et qui nous paraît évidente.

Donc, au lieu de la fameuse accélération dont on nous rebat les oreilles en permanence, on a là un “ralentissement croissant”. C’est complètement en opposition avec ce que les gens sont prêts à recevoir, à percevoir et à croire.

Le mode plateau

Donc, ils ne le voient pas (ce ralentissement croissant). Ce n’est même pas qu’ils ne le croient pas, ils ne le voient pas, car cela ne correspond pas au schéma de pensée qu’ils sont prêts à accepter (parce que la propagande a finalement réussi à leur faire croire que “tout allait toujours plus vite”).

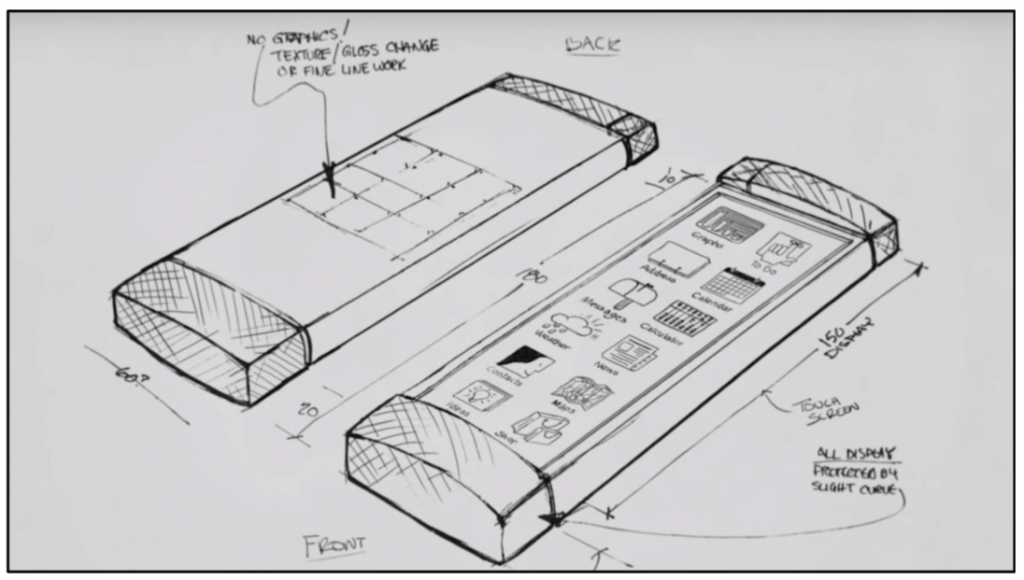

Ce phénomène des retours décroissants et du ralentissement croissant, il est à l’œuvre partout et tout le temps sans qu’on en soit conscient. Si on prend les smartphones comme exemple, le gros du progrès a été réalisé avec la première génération d‘iPhone. Dès la troisième, nous sommes passés à un rythme d’innovation beaucoup moins fort, chaque nouvelle itération ne propose que des avancées marginales (retours décroissants ET ralentissement progressif), on est passé en mode “plateau” sans même s’en apercevoir, car, entretemps, une autre mode a pris le dessus sur la précédente et qui fait qu’on a toujours l’impression d’être dans le même courant d’innovations submergeantes, qui sature les possibilités de perception d’un public non-spécialisé qui, du coup, en déduit fort logiquement que “tout va toujours plus vite” même si, incontestablement, ce n’est pas le cas.

Comme toutes les idées reçues, il s’agit d’une stupidité sans nom et il suffit de réfléchir un peu pour se rendre compte de son absurdité : si tout allait toujours plus vite, il y a un moment qu’il n’y aurait plus aucun délai entre une découverte et son application avec sa généralisation dans la foulée…

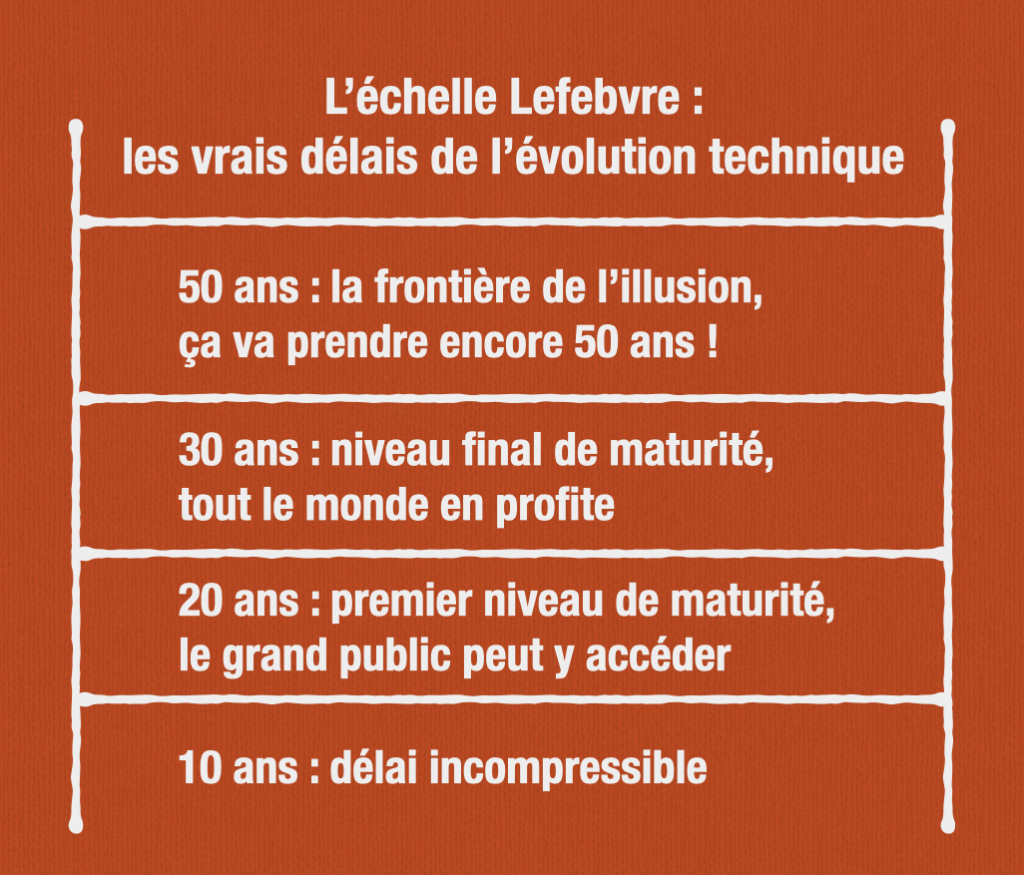

Or, un simple examen des progrès techniques les plus récents démontre que nous butons toujours sur un délai incompressible de dix ans (oui, dix ans) entre une découverte et ses premières applications et qu’il faut encore vingt à trente ans pour atteindre un premier seuil de généralisation. On est donc loin du “tout va toujours plus vite”… Voir à ce propos => https://www.redsen-consulting.com/fr/inspired/tendances-decryptees/les-grands-principes-de-levolution-1-la-maturation

Peu de sources, trop de diffuseurs

Mais cette confusion est inévitable, car liée à notre capacité de perceptions limitées et au fait qu’on aille toujours vers le plus facile. Et le plus facile, c’est de retenir les éléments qui correspondent à notre schéma de pensée (et d’éliminer les autres), auxquels on peut adhérer et avec lesquels on a “l’impression de comprendre” plutôt que de devoir reconsidérer ses filtres, faire une vraie analyse, se mettre à penser pour de vrai, à se lancer dans une analyse critique. Il est plus facile et confortable d’avaler des contenus qui, en fait, ne sont que des résumés (éventuellement de façon abusive sous couvert de vulgarisation) d’éléments lus ailleurs et regroupés en quelques copier-coller à faible valeur ajoutée, car mal compris et mal digérés.

La prochaine victime : l’informatique quantique

Le battage médiatique est constitué de ces redites reprises ad nauseam, car il y a très peu de sources et beaucoup de diffuseurs (comme il y a peu d’agences de presse et beaucoup de chaines de TV…). On voit ce mécanisme encore utilisé actuellement à propos de l’informatique quantique avec des promesses délirantes alors qu’on n’est qu’au tout début de ce domaine radicalement nouveau (voir plus à ce propos ici => https://www.redsen-consulting.com/fr/inspired/tendances-decryptees/linformatique-quantique-pour-bientot).

Je vous encourage à penser par vous-même en vous libérant des carcans de la propagande, toute la propagande, y compris dans le domaine hi-tech où elle n’est pas moins présente ni insidieuse… Remettez en cause les analyses, y compris la mienne. La bonne attitude sur le plan intellectuel n’est pas de suivre le troupeau mais bien de tirer ses propres conclusions en fonction de votre contexte et de vos contraintes.

L’E-sport est en train de devenir un phénomène de société

Publiée le 20 janvier 2020 sur Linkedin

Avertissement – Je n’ai pas vraiment “rédigé” cet article : j’ai pris des éléments des différentes sources citées à la fin de cet article et je les ai ordonné de façon cohérente. Plus un travail d’édition (beaucoup de copier/coller, un peu de corrections et de reformulations) que de rédaction donc…

Dans l’e-sport, la progression des récompenses reflète la croissance de ce domaine. En 2013, à Sydney, la bourse était de $7000 pour le tournoi d’esport organisé à ce moment-là. Avance rapide jusqu’à aujourd’hui et l’on voit que ce même tournoi de Sydney offre désormais une bourse de $350 000 à se partager entre les participants, une inflation certaine !

L’e-sport est désormais de plus en plus reconnu comme une activité sportive, car il fait appel aux compétences personnelles des joueurs comme le réflexe, l’acuité visuelle, la précision, la stratégie ou la communication — des compétences utilisées dans des sports tels que les échecs, le sport automobile, le tir à l’arc ou les sports collectifs.

Des débuts timides puis fracassants

Les débuts de l’e-sport commencent dès 1990, entre autres grâce au jeu Quake. Ces premiers événements ne sont “que” des rassemblements de plusieurs dizaines de personnes. Ces derniers ramenaient leur propre ordinateur et s’affrontaient en LAN (Local Area Network). Puis avec la sortie d’autres jeux propices à l’e-sport, tels que Starcraft ou encore Trackmania, l’e-sport s’est diversifié sur plusieurs autres styles de jeu.

Les années 90 ont aussi vu l’essor des jeux de combat et des tireurs à la première personne (FPS). Les compétitions opposaient désormais joueur contre joueur au lieu des meilleurs scores. Cependant, c’était un titre de “stratégie en temps réel” qui allait littéralement changer la donne…

Sorti en 1998 pour PC, Starcraft avec son robuste mode multijoueur utilisait Internet pour jouer en ligne et en compétition. Il s’agissait d’un phénomène sans précédent en Corée du Sud. Les tournois Starcraft ont germé et les matchs ont été télévisés sur plusieurs stations. Les joueurs ont commencé à devenir pro, à former des équipes et à récolter des parrainages rémunérés avec des marques, avec des campagnes publicitaires. Ce fut la vraie naissance de l’esport.

La professionnalisation du jeu vidéo au sens large vient ensuite en 1997 avec la création de la Cyberathlete Professional League, revendiquant l’existence d’un système sportif dans lequel des équipes composées de joueurs, auxquelles viennent parfois s’ajouter des informateurs, managers, entraîneurs et sponsors s’entraînent régulièrement sur des jeux dans un but purement compétitif.

L’essor de l’e-sport

La compétition et les rencontres internationales se sont d’abord développées avec des FPS tels que Counter-Strike, entre autres. Mais le progrès du milieu compétitif suivait généralement celui des jeux vidéo : ainsi, en 2008, l’Electronic Sports World Cup a retenu de nouveaux jeux tels que Quake III Arena ou encore TrackMania Nations ESWC. Ainsi en élargissant son panel de jeux, l’e-sport avait davantage de chances de toucher un public plus large.

L’essor de l’e-sport a fait émerger de nouveaux métiers, celui de joueur professionnel ou bien de streamer (d’abord sur Twich, la plateforme pionnière en la matière et désormais sur YouTube). Avec cet élan rassemblant plusieurs millions de personnes, des acteurs majeurs s’intéressent à cette nouvelle discipline.

Mais c’est essentiellement en 2010 que l’on assiste à un véritable progrès dans le domaine compétitif avec l’ajout de jeux à l’e-sport tels que Hearthstone, StarCraft II, FIFA, les nouveaux volets de Call Of Duty et Counter-Strike, Dota 2 ou encore le très prisé League of Legends. De plus, le développement de la diffusion de ces rencontres grâce à des WebTV spécialisées dans ce domaine tels que MilleniumTV, OrigineTV, NetGaming, YouTube ou encore Twitch, a permis d’étendre l’influence de l’e-sport sur internet notamment. Ainsi, en 2014, on a recensé 89 millions de spectateurs (via ses plateformes) réguliers lors de compétitions de grande envergure et pas moins de 117 millions de spectateurs (toujours via ses plateformes) occasionnels.

Ce développement si rapide et efficace est également dû aux sponsors qui financent les rencontres et certaines équipes professionnelles ; on peut citer Intel ou AlienWare entre autres, qui organisent la majorité des rencontres en louant des salles et des stades entiers, en fournissant le matériel, ou encore en offrant la récompense à l’équipe gagnante.

Aujourd’hui, l’e-sport ne cesse d’attirer les amateurs et suscite même l’attention de nombreux journaux qui ne sont d’ordinaire pas spécialisés dans le domaine du jeu vidéo.

Et en France ?

En France, l’e-sport a commencé à faire parler de lui en 2010, avec le progrès des compétitions internationales.

On assiste en 2016 à la création de compétitions nationales telles que la e-ligue 1 sur la série FIFA, projet soutenu notamment par l’éditeur de jeux vidéo Electronic Arts.

Ainsi en 2016, l’e-sport en France a généré un revenu global de 22,4 millions de dollars d’après PayPal, et plus de 27 millions en 2017. L’hexagone est le troisième pays européen en termes d’audience pour l’e-Sport. En 2017, 37 millions de téléspectateurs en Europe regardaient régulièrement les compétitions. De leur côté, les Français étaient plus de 2 millions derrière leur écran. Un chiffre qui pourrait atteindre 2,8 millions en 2019. À titre comparatif, ces audiences sont équivalentes à des programmes télévisuels tels que les Césars ou encore les Victoires de la musique.

Le pays y voit une occasion de se développer dans un secteur en pleine expansion. Annoncée en 2018, la FFF (Fédération Française de Football) a décidé de lancer une équipe de France d’e-Sport.Toujours côté foot, le PSG s’est lancé dans l’E-sport en Octobre 2016 en s’associant avec Webedia, une entreprise spécialisée dans les médias en ligne.

De leurs côtés, les chaînes de télévision et les constructeurs s’activent aussi et y voient une opportunité grandissante. M6 a annoncé en février 2018 une participation minoritaire dans Glory4Gamers ou encore Renault qui a rejoint les rangs de Team Vitality en créant sa propre équipe « Renault Sport Team Vitality ».

La plupart des grands groupes médias français investissent aussi dans le secteur : Webedia en rachetant Oxent (développeur de l’e-Sport platform Tournament), Lagardère Sport avec Team Roccat, Vivendi avec Canal eSport Club.

Une ruée vers l’or au niveau mondial ?

L‘E-sport concerne aussi les jeux mobiles et ainsi Alphabet Inc, le conglomérat détenant Google et ses services, a investi 120 millions de dollars (en janvier 2018) dans une société chinoise, Chushou. C’est une société qui propose une plateforme de streaming de jeux mobiles, et plus particulièrement de jeux compétitifs. Cette dernière a déjà attiré plus de 8 millions de streamers. Leur objectif étant d’aider la plateforme à se développer en Chine et à l’international.

Les recettes de l’e-sport (850 millions de dollars en 2018, estimations) sont estimées à 10 milliards de dollars en 2030. En 2018, plus de 100 millions de dollars ont été distribués aux gagnants des compétitions. Ces chiffres peuvent paraître démentiels pour une discipline encore méconnue du grand public. Cependant, la finale mondiale du jeux-vidéos League of Legends a réussi à remplir un stade olympique, rassemblant ainsi plus de 40.000 personnes. Elle était aussi diffusée en direct et à réuni plus de 60 millions de spectateurs uniques.

Malgré des rémunérations de plus en plus faciles et importantes, les principaux revenus de la majorité des joueurs e-sport restent les plateformes de streamings (YouTube, Twitch) grâce aux dons ou aux publicités.

Certains acteurs déjà présents dans l’e-sport essayent de faciliter l’arrivée de cette discipline. Que ce soit un streamer qui sponsorise un joueur professionnel ou encore une chaîne de télévision qui ne diffuse que de l’E-sport.

L’e-sport étant une discipline naissante, certains points importants à son succès auprès du grand public posent encore problèmes. L’un de ce derniers est le nombre de d’événements organisés par différentes structures, de ce fait il peut y avoir plusieurs champions sur un seul et même jeu. C’est pour le moment le point faible de l’e-sport, il n’existe pas de structure officielle pour le représenter. C’est une des raisons pour lesquelles la fédération mondiale de Jeux Olympiques ne l’a pas encore accepté.

Malgré cela, l’OCA (Comité Olympique Asiatique) a annoncé sa volonté d’intégrer l’E-sport au programme des jeux asiatiques de 2022.

Toutes les disciplines sportives sont concernées ou presque !

On a déjà évoqué le foot et League of Legends qui sont deux piliers du développement de l’e-sport mais, bien sûr, d’autres secteurs sont aussi concernés même si certains prennent un peu le train en marche.

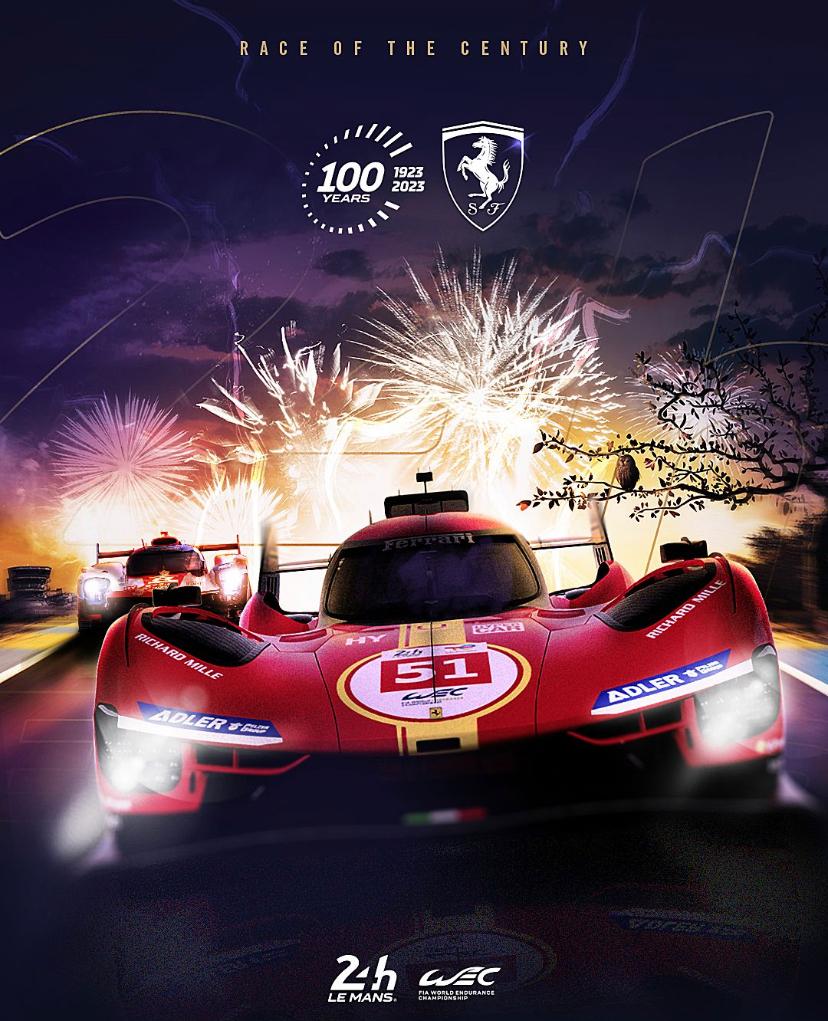

C’est le cas des sports-mécaniques où, en 2019, on a enfin vu un vrai décollage de la discipline. Que ce soit pour le MotoGP, Le Mans ou la Formule Un, des championnats officiels sont organisés et les vraies équipes y engagent des SimRacers super aiguisés. L’argent est au rendez-vous et cela aide à expliquer pourquoi après avoir tardé, le décollage n’en est que plus brutal.

Conclusion : les lignes sont en train de bouger

Il est incontestable que l’e-sport est en train de prendre sa place dans notre société des loisirs et du spectacle. Il est déjà possible de faire carrière, en tant que sportif professionnel, sans jamais aller sur le “vrai” terrain. La compétition est féroce et les meilleurs s’entraînent de façon “effrayante” (Marc Marquez qui est plutôt du genre à être un bosseur et un perfectionniste, a été étonné de voir l’engagement et la précision des meilleurs pilotes participants au championnat MotoGP en e-sport). La croissance est très forte car les sponsors pensent qu’ils ont enfin trouvé la recette magique pour toucher les “jeunes”… Du coup, l’argent coule à flot. Pour combien de temps ?

Alain Lefebvre – Janvier 2020

Sources utilisées pour cet article :

https://www.linkedin.com/pulse/exponential-esports-growth-from-7000-350000-australian-chris-smith/

https://www.geekslands.fr/item/1312-l-essor-de-l-e-sport-dans-le-monde/

https://www.forbes.fr/business/la-revolution-du-e-sport/

https://www.autoblog.com/2019/11/01/esport-racing-series-guide-history/

http://www.jeuxvideo.com/news/772751/google-investit-dans-l-esport-mobile-en-chine.htm

http://www.lepoint.fr/sport/jeux-video-l-e-sport-en-pleine-croissance-08-12-2017-2178103_26.php

https://www.la-croix.com/Sport/Ce-sport-derange-monde-sportif-2017-05-12-1200846649

http://blogs.lecolededesign.com/veille/2018/01/11/lessor-de-le-sport/

https://www.lequipe.fr/Esport/Actualites/Esport-adrien-zerator-nougaret-sponsorise-un-joueur/864342

http://www.gameblog.fr/news/72810-es1-la-chaine-100-esport-a-une-nouvelle-date-de-lancement-et

http://www.lepoint.fr/sport/jeux-video-l-e-sport-en-pleine-croissance-08-12-2017-2178103_26.php

http://www.lepoint.fr/sport/on-espere-que-l-e-sport-prendra-toute-sa-place-au-psg-10-01-2018-2185260_26.php

Les orphelins de leur passé numérique

Publiée sur Linkedin le 27 janvier 2020

C’est récemment que j’ai réalisé ça : on parle beaucoup de big data, de la prééminence de la donnée, y compris au niveau individuel, mais la réalité est tout autre… La réalité, c’est que de plus en plus de gens sont des « orphelins de leur passé numérique » !

J’ai compris cela en voulant migrer le contenu du téléphone de mon épouse, depuis son ancien iPhone qui commençait à accuser le poids des ans vers un Pixel 4 flambant neuf. Tout s’est bien passé et la procédure de migration conçue par Google (il y a même un adaptateur de prise USB pour faire face à tous les cas) est bien faite et efficace… sauf en ce qui concerne l’historique des conversations WhatsApp !

Je me suis penché sur le problème puis j’ai plongé dans ce trou noir et je dois avouer que j’ai eu du mal à en sortir… Rien ne fonctionne, ni même l’utilitaire dr.phone (payé 30 euros), il a fallu que je transfère à la main, morceau par morceau, l’historique de nos échanges afin qu’il ne soit pas perdu, qu’elle puisse le retrouver sur son nouveau téléphone tip-top. Si ça m’a pris tant d’efforts à moi, vous imaginez pour les gens « ordinaires » ?

En effet, en dépit des efforts des GAFAM, chaque migration, chaque passage d’un appareil à l’autre, chaque changement de logiciel et chaque changement de smartphone se passe mal, la plupart du temps : les procédures sont complexes, les gens sont peu enclins à les suivre et les bugs et situations inédites sont encore monnaie courante. Du coup, on a nouveau smartphone tout neuf oui, mais vide la plupart du temps… aie.

Or, nous avons tous des photos, des vidéos et des textes (voir des présentations) que nous voulons garder, absolument. Bien entendu, se pose d’abord un problème de place : les photos que nous prenons à l’occasion sont bien plus nombreuses qu’avant et elles pèsent plus lourd aussi. Même problème pour les vidéos et ainsi de suite (mais, bien sûr, c’est pour ces deux types de contenus que cet aspect se fait le plus sentir). Collectivement, nous produisons toujours plus de contenus chaque année, encore bien plus que ce qui a été produit jusque-là. Mais, de toute cette masse, quelle est la part qui est gâchée, perdue, inaccessible ?

Eh bien il s’avère quelle n’est pas négligeable. Dans cette ère du jetable, du plastique à usage unique, des smartphones qu’on remplace et déclasse pour un oui ou un non (en dépit de leur prix !), notre production numérique est difficile à traiter comme un bien qui est destiné à durer, à rester avec nous, à travers le temps, les âges, les générations.

Dans notre petite famille, nous avons un enregistreur vidéo (un Caméscope, c’est ainsi qu’on appelait cela il n’y a pas encore si longtemps) depuis 1990. Depuis, nous avons systématiquement converti et conservé précieusement ces enregistrements. Nous avons des serveurs Synology configurés en RAID pour cela et nous pratiquons des sauvegardes sur le mode 1-2-3 systématiquement et depuis des années (au passage, je recommande le service Backblaze…). Nous sommes parés pour les situations « normales », mais on ne sait jamais ce qui va menacer votre patrimoine de données, d’images, de vidéos… Nous tenons à ces images et à ces vidéos, nous considérons qu’elles sont une part de nous. Et nous nous apercevons qu’il est toujours plus difficile de les stocker, de les convertir, de les trier et ainsi de suite.

J’imagine que certains doivent avoir les mêmes difficultés que nous, mais que beaucoup d’autres renoncent à tous ces efforts. Nous entrons dans l’ère des orphelins du numérique où nous produisons beaucoup de données, mais où nous en perdons autant à chaque occasion.

Quand la réalité rejoint la fiction

Publiée sur Linkedin le 6 février 2020

Je viens de regarder un documentaire sur Arte : “Des robots et des hommes”. Un contenu sur la robotique, l’IA et les questions sociétales que ces sujets posent… Rien d’exceptionnel, mais j’ai pour habitude de regarder plus ou moins “tout” ce qui passe à ma portée sur ces sujets (et d’être souvent déçu par les banalités et les idées reçues qui y sont ressassées !).

Cependant, cette fois, une séquence a particulièrement retenu mon attention. À partir de 46:30; on y voit une jeune femme qui explique son quotidien au travail à Londres… Depuis dix ans, elle livre des colis (genre Uber Eats) en vélo et explique que depuis ses débuts, les choses ont bien changé : avant, elle avait un manager qu’elle voyait de temps en temps et, désormais, tout ce fait à travers une app, y compris les sanctions !

Voir à https://www.arte.tv/fr/videos/058352-000-A/des-robots-et-des-hommes/

Cette évolution déshumanisée m’a rappelé exactement le contexte d’un roman de SF écrit par Marshall Brain : Mana (voir à https://marshallbrain.com/manna1.htm).

Dans Mana, une chaîne de fast food remplace tous les managers par une application reliée aux employés par un casque audio où elle donne ses ordres. Les employés peuvent et doivent indiquer où ils en sont par un microphone intégré au casque audio. Les humains sont ainsi transformés en quasi-robots qui doivent obéir minute par minute à une application qui trace tout, n’oublie rien et sanctionne au moindre travers.

Il est assez saisissant de voir qu’on en est là, déjà. Et nul besoin d’une AI sophistiquée pour atteindre ce genre de résultat : il suffit d’un programme comme les plateformes de services telles qu’Uber et autres mettent en œuvre depuis des années. Les évolutions les plus radicales ne demandent pas forcément un saut technologique important, il suffit d’intégrer finement ce qui est déjà largement disponible…

Comment reconnaître une mode technique exagérée ?

Publiée sur Linkedin le 9 février 2020

En ce moment, les médias nous expliquent avec force que “l’informatique quantique”, c’est l’avenir et que ça va tout changer…

Les médias n’ont pas peur du ridicule, ils sont là pour faire de l’audience, à tout prix. Comme la nature, les médias ont horreur du vide. Quand la mode précédente commence à s’essouffler (au choix, la Blockchain, la voiture autonome ou encore l’IA), ils en cherchent une autre, n’importe quelle autre du moment que son contenu paraît sexy et accrocheur.

Car la propagande technique a ses règles qu’elle suit rigoureusement. Tout d’abord, pour vendre sa nouvelle mode, elle emploie toujours les mêmes arguments. Ils sont faciles à reconnaître et vous les connaissez déjà. C’est le fameux “c’est tellement important que ça va concerner tous les domaines applicatifs”… en clair, ça sera “tout pour tous”. Cette proposition est absurde et toujours démentie, mais elle joue son rôle. Celui d’allumer les signaux d’alerte dans l’esprit des lecteurs et donc d’attirer leur (faible) attention.

En effet, la grande majorité des gens n’analyse nullement ce qu’il voit passer, ils se contentent de réagir, nuance. Et pour déclencher cette réaction (émotionnelle plutôt que rationnelle, forcément), rien de tel qu’un argument massue s’appuyant sur la peur : tout va changer grâce/à cause de cette technologie, préparez-vous !

Dans le cas de l’informatique quantique, ce serait risible si ça n’était pas désolant de voir que les mêmes ficelles (grossières) sont utilisées encore et encore. Car, soyons sérieux, l’informatique quantique n’en est qu’à son tout début et ne va pas produire des résultats significatifs avant au moins une dizaine d’années. C’est comme si on extrayait un prématuré de sa couveuse en prétendant qu’il allait battre le record du 100 m… ridicule et dangereux.

Les technologies mises en lumière trop tôt souffrent de cette exposition médiatique prématurée. Certes, dans un premier temps, l’argent se met à couler à flots sur les quelques équipes de recherche concernées (notez bien, on parle ici d’équipes de recherche…), mais, quand la déception va arriver (et elle arrive toujours) ces crédits vont se tarir brutalement.

La technologie ainsi malmenée ne va pas disparaître, elle va continuer à évoluer lentement en mode discret, car c’est ainsi que cela fonctionne : les “révolutions en une nuit” mettent vingt ans à maturer discrètement. La biotech ou la nanotechnologie ont été des déceptions, car mises en avant trop tôt, bien trop tôt. Mais depuis qu’elles sont retournées dans l’obscurité, elles continuent à évoluer, à progresser, lentement mais sûrement. Un jour, elles reviendront sur le devant de la scène pour enfin produire leurs effets et changer la donne.

En attendant, apprenez à décoder la propagande et évitez de tomber dans les “pièges à gogos” qui sont continuellement renouvelés.

La discrimination du futur : entre les “pensants” et les “lobotomisés”.

Publiée sur Linkedin le 19 février 2020

Il suffit de regarder la télé 5mn pour en être convaincu (surtout si vous ne l’aviez pas vu depuis longtemps) : les programmes tels qu’ils sont devenus aujourd’hui ne s’adressent qu’aux plus débiles d’entres nous (y compris et surtout les pubs qui atteignent désormais des sommets !).

Le vrai fossé, la vraie discrimination du futur n’est pas entre les races, les gros et les moins gros, les jeunes et les moins jeunes (j’en oublie forcément mais je vous laisse compléter la liste) mais entre ceux qui réfléchissent encore par eux-mêmes (que, par commodités, nous appellerons les “pensants” à partir d’ici) et qui sont forcément une minorité (de plus en plus infime, hélas) et ceux qui ont abdiqué leur cerveaux (ou ce qu’il en reste) et qui s’abreuvent de ces programmes (que ça soit à la TV, sur YouTube ou ailleurs, là encore je ne vais pas faire la liste, vous voyez l’idée). Nous appellerons les membres de cette majorité croissante (hélas), les lobotomisés (ce qui situe assez bien leur état).

Ce fossé existe déjà, il se creuse un peu plus tous les jours (les pensants sont de moins en moins nombreux, les lobotomisés sont de plus en plus débiles) mais ce n’est encore rien par rapport à ce qu’on risque de voir se concrétiser à l’avenir. En effet, imaginez le scénario suivant (qui, on va le voir, n’est même pas exagéré, ni sur le plan technique, ni sur le plan sociétal) : un ou plusieurs des GAFAM finissent par mettre au point et commercialiser des lunettes permettant d’obtenir une “réalité augmentée” permanente tout en restant discrètes (pas un gros machin façon masque de VR) et sachant resté connectées au réseau en toutes circonstances (grâce à la 5G, c’est pas si loin). Eh bien, je pense que ce dispositif (porté en permanence bien sûr) servira principalement aux lobotomisés afin de pouvoir se gaver de leurs “contenus favoris” tout au long de la journée. On peut même imaginer qu’il y aura deux versions de ces lunettes : une, assez coûteuse, où c’est vous qui choisirez ce qui s’affiche et une autre, bien moins cher car “sponsorisée” (par TF1 ou M6, au hasard) où vous n’aurez plus le choix des contenus qui s’affichent (et où, ô surprise, il y aura une tranche de pub supplémentaire…).

Une que ce scénario sera en cours de réalisation, nous pouvons dire adieu à la grande majorité de la population : ils seront perdus, inaccessibles et tout échange intelligible avec eux sera progressivement impossible.

J’exagère, vraiment ?

Toujours plus vite… vers quoi ?

Publiée sur Linkedin le 29 février 2020

Les apôtres de la modernité nous le répètent sans se lasser : tout va de plus en plus vite !

Faut-il les croire ?

Je vous l’avoue, j’ai une position tout à fait opposée : non, je ne pense pas que “tout va toujours plus vite” même et surtout le progrès technique !

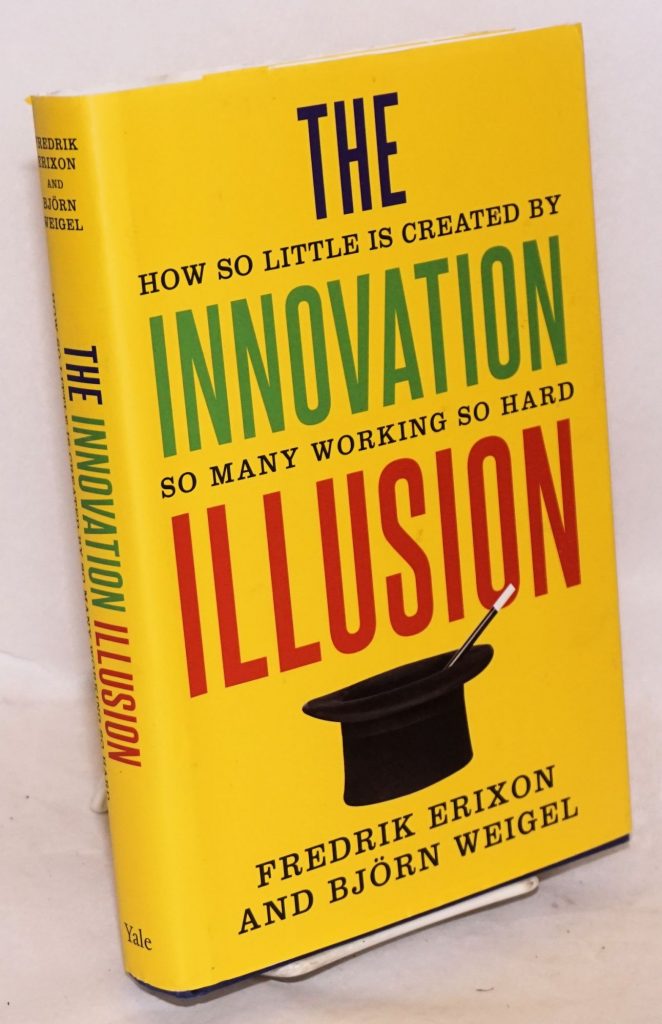

J’ai même publié un livre à ce sujet qui démontre la stagnation des principales technologies à la mode. Sur Linkedin, je ne manque jamais de pointer les incohérences de cette nouvelle pensée unique tout comme les autres effets pervers de la propagande hi-tech (la fixation sur l’IA et/ou la Blockchain).

En vérité, à la place du “toujours plus vite”, ce que je constate, c’est plutôt un “toujours les mêmes défauts mais en plus grand nombre” !

Toujours plus de défaillances, d’impasses et de bugs dans la sphère numérique grandissante.

Soyons honnête et, pour le moment, la réalité de l’expérience utilisateur est plus souvent médiocre qu’idyllique dans le monde merveilleux de “la révolution digitale”… En effet, il suffit d’évoquer ces procédures qui passent par des successions de formulaires pour finalement échouer au dernier moment pour différentes raisons (dépassement du temps prévu, rupture réseau, données manquantes ou, le plus souvent, aucune raison évoquée mais un simple message “erreur, réessayer dès que possible” qui met en rage même le plus zen d’entres nous !), ces applications qui captent vos données mais ne vous permettent pas de migrer votre historique quand vous changez de smartphone, ces GPS qui vous font passer par des parcours soit-disant “optimisés” mais absurdes en pratique… dois-je continuer cette liste des (mauvais) exemples des ratés de la “révolution digitale” que nous subissons autant (voire plus que nous en profitons ?

Mais alors, comment expliquer cette unanimité dans vis-à-vis de cette pensée unique (tout va de plus en plus vite) ?

La réponse se trouve peut-être dans les volumes toujours croissants de ce qui nous est accessible…

X10 de contenus, dans tous les domaines

On en parle moins souvent que de l’accélération (supposée mais facile à réfuter) mais ce qui caractérise vraiment notre époque, c’est cette abondance dans les contenus et ce dans tous les domaines ou presque.

Il y a seulement vingt ans, le monde était très différent de celui d’aujourd’hui. Pas vraiment sur le plan du niveau technologique atteint (qui, j’insiste, stagne) mais bien sur le plan de la diversité de l’offre. Regardez autour de vous et vous constatez une incroyable abondance dans les contenus (de distractions puisque nous sommes dans la société des loisirs en plus d’être dans la société du spectacle, l’une étant la conséquence de l’autre d’ailleurs !) et les offres commerciales qui sont disponibles, le plus souvent à un prix abordable en plus.

Pour celles et ceux qui sont assez âgés pour s’en souvenir, on reste ébahis devant l’incroyable augmentation de l’offre accessible. On peut multiplier les exemples : qui peut encore compter le nombre de chaînes de télévision disponibles (inutile, aucune ne vaut la peine d’être regardée !) ?

Pareil pour les chaînes YouTube et les services en ligne. Je suis écrivain et j’ai pu constater que l’offre de livres sur Amazon avait littéralement explosé alors que les gens lisent moins… allez comprendre !

Oui, je pense vraiment que c’est l’abondance bien plus que la vitesse qui caractérise notre époque. Et, face à ce déferlement, chacun reste médusé. Pas étonnant que, faute d’analyse plus approfondie, on finit par “penser” que “tout va toujours plus vite”…

Nous sommes trop nombreux et ça nous entraîne sur une pente dont nous ne voulons pas…

Publiée sur Linkedin le 15 avril 2020

Oui, c’est un peu long comme titre et pourtant, c’est exactement cela… Tout d’abord, nous sommes clairement trop nombreux et, ensuite, cela a des conséquences : cette pente dont nous ne voulons pas et qui pourtant s’impose à nous et nous entraîne.

Pas besoin de trop revenir sur le “nous sommes trop nombreux” mais, si ça n’est pas déjà le cas, je vous conseille de lire ce petit récit que j’ai publié il y a plus d’un an (Un nouveau récit de fiction : « Les terribles trop »…). Une fois ceci posé, que constatons-nous ?

Notre nombre qui augmente en permanence conduit à toujours plus de densité. Cette densité a des conséquences en cascade, on peut le voir en ce moment d’urgence sanitaire mais ce qu’un aspect (même s’il est dramatique et actuellement proéminent). Car cette augmentation se paye avec d’autres croissances à tous les étages : plus d’impôts (lors de la “grippe de Honk Kong de 1969, la pression fiscale en France n’avait rien à voir avec son niveau de 2020…), plus de réglementations (et moins de libertés du coup) et plus de contraintes de toutes natures. Plus la population prend de la place, moins il y a de confort, de sécurité et de liberté pour tous, il faut bien le dire !

Or, en ce moment, ces “terribles trop” ne sont pas assez mentionnés, presque ignorés alors qu’ils sont vraiment à l’origine de nos problèmes (et pas seulement la crise actuelle qui, bien sûr, nous obnubile).

L’époque est favorable aux tartuffes

Publiée sur Linkedin le 20 avril 2020

En ces temps troublés, que voit-on ?

Des tartuffes de tout acabit qui tentent de faire passer des vessies pour des lanternes !

En effet, on ne compte plus les organismes de formations qui, auparavant, crachaient leur venin sur le E-learning et qui, aujourd’hui, le mettent en avant sans aucune vergogne… Pareil pour le télétravail, tous ces petits chefs qui n’en voulaient pas (surtout pour de mauvaises raisons) et qui tournent leurs vestes pour en vanter désormais les mérites…

Inutile de vous donner d’autres exemples, vous avez compris et vous pourriez citer d’autres imposteurs du même ordre. L’époque n’est pas à la vertu, elle est à celui qui se reniera le plus vite !

Le télétravail est une lentille grossissante !

Publiée sur Linkedin le 27 avril 2020

Les managers qui veulent à tout prix “fliquer” leurs collaborateurs qui travaillent à distance sont complètement “à côté de la plaque” : le télétravail agit en fait comme un révélateur. Celles et ceux qui étaient productifs au bureau le seront encore plus ailleurs, à distance, loin des contraintes paralysantes du “tout le monde au même endroit” (réunion chronophages, interruptions “sociales” constantes, etc.). En revanche, celles et ceux qui étaient performants pour “brasser de l’air” dans le contexte hautement social du bureau vont se retrouver fort dépourvus face à un écran, seul et sans public. C’est en cela que les situations de télétravail sont des révélateurs, des lentilles grossissantes qui permettent de départager les bons éléments productifs des “acteurs qui savent juste faire semblant” d’être de bons éléments.

Il en est de même pour le management. Celles et ceux qui insistent pour mettre en place ces dispositifs de surveillance sont du même acabit : conscients de leurs faiblesses en matière d’entraînement et de charisme, ils tentent de compenser en jouant les “petits chefs” et se transforment en “surveillants” car ils sont incapables de jouer pleinement leur rôle.

Ce que j’ai appris en 60 ans

Publiée sur Linkedin le 30 avril 2020

Hier, j’ai eu 60 ans. Je dois avouer que, quand j’avais la vingtaine, cela représentait pour moi un horizon si lointain qu’il paraissait tout à la fois inaccessible et complètement indésirable. Pour tout dire, je n’arrivais pas à me projeter “vieux”. Aujourd’hui bien sûr, j’ai une vision différente et je ne me vois toujours pas “vieux”.

Cependant, ce parcours qui s’est déroulé si vite, a eu le temps de m’apprendre une chose ou deux que je voudrais partager avec vous à travers cet article. Oh, je ne suis pas devenu un parangon de sagesse parce que j’ai atteint 60 ans mais laissons la modestie de côté pour tenter de transmettre ce que la vie m’a appris, jusqu’ici…

1- Apprendre

On ne cesse jamais d’apprendre et, surprise, c’est de plus en plus agréable, désirable même. S’il n’y a qu’une chose à apprendre aux jeunes, c’est ça : l’envie d’apprendre. Avec ça, vous êtes armé pour tous les défis.

2- Transmettre

C’est une pulsion qui s’impose à vous, l’âge venant. Ce que vous avez accumulé (et là, on ne parle pas de richesses mais de connaissances…), vous avez subitement envie de le transmettre, non, besoin de le transmettre. Pour que cela ne soit pas perdu ?

Peut-être, peu importe, la pulsion est là, il vous faut lui obéir.

3- Incertitude

Rien n’est sûr, surtout pas ce qui est annoncé comme certain. Attendez-vous à des déceptions si vous croyez celles et ceux qui vous annoncent des certitudes. Restez serein aussi, rien n’est sûr veut aussi dire que le pire n’est jamais certain… c’est déjà ça !

4- Amour, amitié

“Rien ne compense l’échec au foyer” me disait souvent un vieil ami… ô combien vrai !

Concentrez-vous sur l’essentiel : réussir à maintenir l’amour au sein de votre foyer. Cela semble évident, pourtant nombreux sont celles et ceux qui échouent en se perdant dans des objectifs divers qui ne sont PAS le but de la vie.

Si l’amour est important, ne négligez pas l’amitié qui est source (abondante) de bonnes surprises (et qui, souvent, dure plus longtemps…).

5- Lâcher prise

Je n’ai jamais rien achevé de bon en étant arc-bouté sur ma tâche. “Être à cran” ne vous aidera pas. Apprenez le lâcher prise, le plus tôt possible. D’abord parce que c’est long à maîtriser ensuite parce que ça sert longtemps.

6- Échecs, réussite

“Le succès, c’est d’aller d’échec en échec sans perdre son enthousiasme” (une citation célèbre attribuée à WINSTON CHURCHILL). Soyons clair, j’ai échoué très souvent, bien plus souvent même qu’il n’est confortable de l’avouer !

Mais échouer ne veut pas dire “se tromper”. Tous ces échecs m’ont apporté quelque chose, tous m’ont aidé à bâtir les quelques succès que j’ai pu achever. Sans les (nombreux) premiers, il n’y aurait pas eux les (quelques) seconds.

7- Rester positif

“Pourquoi s’inquiéter ?” dit le sage hindou… Il ne s’agit pas d’être positif à tout prix même au milieu des pires malheurs. Mais il suffit de se rendre compte que la beauté est partout (oui, vraiment partout, il faut juste chercher à la voir…) pour réaliser que nous avons le choix : nous plaindre (sans que cela fasse avancer quoi que ce soit) ou apprécier ce court séjour sur terre pour ce qu’il nous apporte.

8- Regard des autres

Ah si on pouvait se passer du regard des autres !

Mais on peut en fait. C’est lorsqu’on réalise finalement que le regard des autres ne vous apporte rien qu’on peut s’en libérer. Et cette liberté vous rend plus fort et plus heureux. C’est comme toute libération, il n’y a que le premier pas qui coûte…

9- Immuable

C’est comme les certitudes : rien n’est immuable. Riez quand vous entendez “pour toujours”. Aucune situation ne perdure, aucune domination n’est épargnée par le déclin, aucune position n’est acquise “pour toujours”. Libérez-vous de ce genre de boulet.

10- Sens de la vie

Ne cherchez pas le sens de la vie dans la philosophie ou dans l’ésotérisme, vivez-le à travers de profondes gratitudes : transmettre la connaissance, rayonner l’amour de vos proches, percevoir la beauté du monde, le voilà le sens de la vie.

Enfin, un dernier enseignement, très personnel cette fois : j’ai compris que je devais laisser une œuvre pour être tout à fait satisfait de mon passage dans ce monde. Cela paraît prétentieux ou trop ambitieux ou trop vain (c’est là où se libérer du regard des autres est utile…). Peu m’importe, c’est ma pulsion actuelle profonde. Peut-être cette “œuvre” restera inconnue, oubliée avant même d’être lue… peu importe, cela est mon moteur, ma motivation et mon devoir pour le temps qui me reste.

Haro sur le télétravail !

Publiée sur Linkedin le 11 juin 2020

Depuis le début du des confinement, on assiste à une véritable campagne de presse orchestrée contre le télétravail. On peut lire, ça et là, des articles résumant tous les inconvénients du télétravail, les témoignages des victimes (!) du télétravail, les inconvénients du télétravail qu’on a pu constater pendant la période de confinement et ainsi de suite.

En vérité tout cela ressemble fort à une ultime réaction de l’ancien monde face aux bouleversements récents du “nouveau monde” qui est en train de se mettre en place.

Il semble bien qu’une partie du management essaie de s’accrocher à ses anciennes prérogatives et fait tout ce qu’elle peut pour cela, y compris avoir recours à ce genre de campagne de le dénigrement. Cela indique surtout son degré d’affolement vis-à-vis de ce bouleversement que nous avons vécu tous ensemble. Car finalement, le télétravail est la seule bonne chose que l’on peut retirer des quelques mois de confinement que l’on vient de vivre en France.

Mais, comme ce mode de collaboration à distance semble insupportable à certains, rien de mieux que d’essayer de le disqualifier à travers des articles de pleurnicheur des nouvelles pratiques. Mais il n’y a pas que le management qui s’affole, c’est également le cas pour les “papillons de nuit” qui profitaient de leur présence au bureau pour brasser beaucoup d’air mais produire très peu. Avec l’avènement du télétravail, ce sont les premiers à être mis crûment devant leur inefficacité. Pour eux, il est clair qu’il vaudrait mieux revenir aux anciennes pratiques.

Cette ultime tentative de ces réactionnaires est bien la preuve, finalement, qu’il faut intégrer aussi largement que possible le travail à distance et affiner ce mode de collaboration sans présence physique. Qu’on le veuille ou non, qu’on l’apprécie ou pas, c’est un vrai progrès dans des pratiques professionnelles. Et tant pis pour les pleurnicheurs qui regrettent l’ancien monde car ils pouvaient l’exploiter et faire semblant de travailler sans trop se fatiguer.

Pour votre bien, restez à l’écart des modes techniques dans l’informatique…

Publiée sur Linkedin le 15 juin 2020

Je le répète à longueur de chroniques et d’ouvrages (à tel point que je pourrais passer pour un affreux rétrograde !) mais l’intérêt des organisations qui utilisent l’informatique n’est pas de suivre les modes imposées par les acteurs du marché qui, dans un bel ensemble, sont tous d’accord pour mettre en avant une nouvelle lubie tous les quatre ans.

Un exemple ? Pas de problème !

La transformation digitale était annoncée il y a quelques années comme une rupture majeure. Cloud, objets connectés, big data, intelligence artificielle et même les drones devaient devenir des technologies omniprésentes et tout révolutionner. En parallèle, de nouveaux entrants devaient s’imposer sur le marché avec leurs modèles d’affaires alternatifs et bousculer l’ordre établi, désintermédiant les acteurs historiques.

Dans la pratique, il y a bel et bien eu des ruptures sur certains secteurs d’activité comme Tesla dans l’automobile, Space X dans l’aérospatial, Revolut et N26 dans la banque de détail ou encore Netflix et Spotify, qui ont effectivement révolutionné l’industrie de l’Entertainment. Les GAFAM et BATX sont quant à eux devenus les premières capitalisations boursières et ont provoqué de profondes adaptations réglementaires sur le plan fiscal et en matière de protection des données personnelles, qui ont des répercussions sur l’ensemble des secteurs d’activité.

Mais il est clair que cette transformation digitale si elle a bien eu lieu dans quelques secteurs est loin d’avoir provoqué la rupture majeure tout azimut annoncée et répétée sur tous les tons.

En somme les ruptures annoncées se sont produites dans quelques cas emblématiques et mis en avant ad nauseam par les thuriféraires de la trop fameuse transformation digitale (elle aussi bien trop mise en avant !). Donc, on a généralisé quelques exemples exceptionnels en voulant faire croire qu’ils pouvaient s’appliquer à tous dans tous les domaines (ce qui n’était évidemment pas le cas, la suite l’a prouvé).

En réalité, c’est la même chose sur le plan technique : ce que les GAFAMs peuvent faire n’est pas forcément généralisable à toutes les organisations utilisant l’informatique (loin de là !). Un exemple éclairant avec l’IA : les GAFAMs ont tous su mettre en application le machine learning de façon spectaculaire mais, en dehors de ces cas extrêmes, c’est le désert !

On serait bien en mal de citer des organisations “ordinaires” ayant pu produire des résultats extraordinaires avec les dernières techniques de l’IA à la mode… Même IBM s’est planté en voulant commercialiser (trop tôt) son programme Watson auprès des intervenants du système de santé américain…

Et cette précaution ne se limite pas à l’IA, il en est de même pour quasiment tous les domaines à la mode !

Par charité, on évitera de poser les questions qui fâchent comme “mais où sont donc les voitures autonomes qu’on nous avait promises ?”.

Bref, vous l’aurez compris, les modes techniques sont toujours présentées trop tôt et vous avez intérêt à “laisser passer votre tour” afin d’en profiter une fois la maturité arrivée.

La prochaine ère de l’IT ? Une pause !

Publiée sur Linkedin le 18 juin 2020

N’en déplaise aux chantres de la “transformation digitale” (punaise, y en a vraiment marre d’utiliser cette expression !), la prochaine ère de l’IT ne sera PAS orchestrée par les développements fabuleux de l’IA ni par les possibilités formidables de la Blockchain (vous avez remarqué ? On en parle moins en ce moment et c’est pas dommage !).

Non, la prochaine ère de l’IT, c’est de faire une pause, tout simplement.

Oui, notez bien la date et retenez que c’est moi qui vous l’annonce car, pour une fois, la prochaine mode, c’est de calmer tout cela et de se concentrer sur des projets concrets, pratiques, les deux pieds bien ancrés au sol.

Mais qu’est-ce qui me permet de faire une prédiction aussi audacieuse ?

Eh bien, deux éléments. 1- Le machine learning affiche ses limites et 2-la loi de Moore est en train de s’effacer…

Fin de partie pour l’IA, winter is coming

Tout d’abord, le hype autour de l’IA dopée au machine learning est enfin en train de se calmer. C’est The Economist qui vient de siffler la fin de partie avec un dossier spécial consacré : après des années de battage médiatique, beaucoup de gens pensent que l’IA n’a pas réussi à délivrer des résultats à la hauteur des promesses (voir à https://www.economist.com/technology-quarterly/2020/06/11/an-understanding-of-ais-limitations-is-starting-to-sink-in).

Je ne suis pas surpris puisque ça fait des années que je l’annonce (voir à http://www.alain-lefebvre.com/avenir-de-lia-lhypothese-85/). Ce qui a été surprenant, c’était de voir que, pendant longtemps, nous étions peu à le dire. Maintenant que The Economist vient de publier ce dossier, le hype en matière d’IA va forcément s’atténuer fortement, enfin !

Vous n’êtes pas obligé de me croire mais, en revanche, vous pouvez lire le dossier de The Economist fort bien fait…

Fin de partie pour la loi de Moore

Le NYT en parlait dès 2016 : la loi de Moore qui s’est vérifiée pendant des décennies est en train de s’effacer (lire à https://www.nytimes.com/2016/05/05/technology/moores-law-running-out-of-room-tech-looks-for-a-successor.html).

En fait, c’est plus important qu’il n’y paraît car, qu’on le veuille ou non, qu’on y croit ou pas, les vrais progrès de l’industrie informatique reposent surtout sur la croissance continue (jusqu’à maintenant) de la capacité de traitement et de stockage.

Gordon Moore, fondateur d’Intel, a observé en 1965 que le nombre de composants pouvant être gravés à la surface d’une tranche de silicium doublait à intervalles réguliers et le ferait dans un avenir prévisible – une idée connue sous le nom de loi de Moore. Credit Paul Sakuma/Associated Press

Pour prendre une analogie, on peut comparer ce domaine (l’informatique) à un grand plan d’eau qui s’étendrait toujours plus en superficie mais resterait peu profond, même en son centre. La surface toujours en expansion représenterait la progression des capacités de traitement (et de stockage) qui ne cesse de progresser (et c’est cette progression qui donne l’impression d’une évolution sans frein) et la profondeur serait à l’image des fonctionnalités qui elles restent très limitées.

Si la loi de Moore est en train de finalement heurter un mur, c’est tout simplement le principal moteur du progrès technique qui est stoppé. Or, pour reparler du machine learning, on s’est vite aperçu que l’entraînement de ces systèmes demandait beaucoup de ressources (vraiment beaucoup) et de plus en plus.

Voyons cet extrait de The Economist (source https://www.economist.com/technology-quarterly/2020/06/11/the-cost-of-training-machines-is-becoming-a-problem) pour situer les choses :

===

Openai, une firme de recherche basée en Californie, a déclaré que la demande de puissance de traitement avait décollé en 2012, alors que l’excitation autour de l’apprentissage automatique commençait à monter. Elle s’est fortement accélérée. En 2018, la puissance informatique utilisée pour former les grands modèles avait été multipliée par 300000 et doublait tous les trois mois et demi (voir graphique). Il devrait savoir – pour entraîner son propre système «Openai Five», conçu pour battre les humains à «Defense of the Ancients 2», un jeu vidéo populaire, il a mis à l’échelle l’apprentissage automatique «à des niveaux sans précédent», exécutant des milliers de processus sans arrêt pendant plus de dix mois.

Des chiffres exacts sur le niveau de ces coûts sont rares. Mais un article publié en 2019 par des chercheurs de l’Université du Massachusetts à Amherst a estimé que la formation d’une version de «Transformer», un autre grand modèle de langage, pourrait coûter jusqu’à 3 millions de dollars. Jérôme Pesenti, responsable de l’IA sur Facebook, explique qu’une session de formation pour les plus grands modèles peut coûter «des millions de dollars» en consommation d’électricité.

===

La progression de cette exigence dépasse de beaucoup ce que la loi de Moore était capable de compenser en temps normal… Et, désormais, elle ralentit. Vous voyez la collision des situations qui est en train de se dessiner ?

Bref, tout cela nous indique fortement qu’une pause est en train de s’installer. Il faut dire que la crise du Covid19 avait déjà ridiculisé (provisoirement ?) tous les tenants du transhumanisme et de l’immortalité. Cette fois, c’est la pause à venir qui va disqualifier les consultants en mal d’audience qui poussent encore et toujours la “transformation digitale” faute d’avoir quelque chose à dire… Tant mieux, qu’ils se recyclent sur autre chose.

Je veux aller vivre en Théorie

Publiée sur Linkedin le 29 juin 2020

Il est toujours très difficile d’avoir un discours contrariant dans le domaine technique parce que, d’une façon générale, le grand public a une perception “hystérique” de la réalité de l’évolution technique. Une perception déformée si le terme “hystérique” vous parait trop fort.

Que vous soyez craintif ou enthousiaste vis-à-vis des progrès techniques, dans les deux cas vous avez tort. La peur n’évite pas le danger et, si vous avez peur des évolutions techniques, peur de vous faire balayer (par Amazon ou par Uber), eh bien soyez sûr que ça arrivera. Car les évolutions techniques significatives finissent toujours par arriver et produisent des impacts importants. Simplement, ça prend toujours plus de temps qu’annoncé (principe de maturation toujours négligé ou sous-estimé).

Dans le même temps, si vous êtes trop enthousiaste en croyant que ces mêmes progrès techniques vont apporter et permettre, vous tendez le ressort de la déception cuisante qui, inévitablement, viendra. Pourquoi ?

Parce que, avouons-le, on est toujours déçu par la technologie et la vitesse de ses évolutions. Car la technologie requiert des investissements d’infrastructures pour sa mise en place, donc, des investissements importants (pensez à ce qui est en train d’être dépensé pour la mise en place de la 5G… et c’est la même chose tous les dix ans en matière de télécom).

Donc, quand on est face à des besoins de financements massifs, on est toujours obligé de “survendre” pour arriver à faire passer la pilule. Alors, forcément, le retour sur investissement va être long, ne va pas être aussi juteux que prévu et ainsi de suite.

En gros, la technologie ne nous décevrait jamais si tout se passait conformément à la théorie. Mais on sait bien que ce n’est pas le cas, jamais le cas. Comme le disait si justement Jean-Louis Gassée “je veux aller vivre en Théorie parce que tout se passe parfaitement en théorie”.

Mais en pratique, c’est autre chose : il y a des retards, il y a des imprévus, il y a des échecs, il y a des déceptions (voir le projet ITER par exemple). Gardez cela en tête la prochaine fois que vous devrez planifier un projet qui s’appuie sur une innovation technologique…

L’accélération est la nouvelle pensée unique (et c’est une connerie monumentale !).

Publiée sur Linkedin le 1er juillet 2020

On vous serine continuellement que tout va très vite, que tout se transforme de plus en plus rapidement et qu’on est submergé par ce maelstrom de nouveautés, les unes succédant aux autres avec toujours plus d’impatience, n’est-ce pas ?

C’est la perception partagée par la plupart des gens. Ils vous le diront : “de nos jours ça va trop vite et on a du mal à suivre”. Ils se sont tellement persuadés que ce soit la vérité qu’ils se la répètent les uns les autres.

La technologie semble responsable d’un flot incessant de nouveautés toutes plus incroyables les unes que les autres, qui se succèdent à une vitesse vertigineuse, croissante d’année en année. Cette accélération paraît si réelle que personne ne songe à la remettre en cause. Pourquoi ne pas y croire d’ailleurs, puisque tous vos sens semblent vous indiquer que c’est véritablement le cas ?

Mais ça ne fonctionne pas toujours de la sorte. Il y a seulement quelques siècles, les gens dans leur immense majorité pensaient que le soleil tournait autour de la Terre et pas le contraire. Il suffisait de regarder la course du soleil dans le ciel pour se rendre compte qu’effectivement, il en allait ainsi. Votre intuition et votre sens logique vous le faisaient imaginer faussement, pourtant à cette époque il était tout à fait logique de penser ainsi et ceux qui affirmaient le contraire étaient très peu nombreux. Aujourd’hui c’est la même chose : tout vous pousse à considérer que le progrès s’accélère continuellement alors que la technologie est en train de ralentir. Bien sûr, il est tout à fait contre-intuitif d’affirmer cela et, au premier abord, personne ne vous croira.

L’état de l’art, dans tous les domaines qui reposent sur la technologie, est en réalité très différent de ce que la propagande veut vous faire penser. Mais alors, me direz-vous, pourquoi nous mentirait-on sur ce sujet ?

C’est la bonne question à se poser : pourquoi la propagande voudrait nous persuader que la technologie est portée par un progrès continu et inextinguible si ça n’était pas le cas ?

À cela il est facile de répondre : la propagande vous ment sur ce sujet, car elle a intérêt à vous peindre le futur avec du rose plutôt que du noir. C’est dans son intérêt de réenchanter l’avenir artificiellement, de façon à ce que les citoyens ne soient pas saisis d’angoisse face aux perspectives toujours plus inquiétantes. C’est même une tendance qui porte un nom, c’est ce qu’on appelle le solutionnisme : faire accepter que tout problème a sa solution et que cette solution est d’ordre technique. Ainsi il n’y a pas matière à s’inquiéter : quel que soit le problème menaçant l’Humanité, la science et la technologie vont y apporter une solution.

Le solutionnisme est une illusion tout comme le progrès continu de la technologie. Cette illusion est une absurdité du même ordre que celle de croire à une croissance économique qui serait continue et infinie.

Il est toujours terriblement périlleux de prédire le futur, et y arriver avec précision est encore plus aléatoire. En revanche, ce qu’on peut faire, c’est extrapoler à partir du passé. Et ce qu’on a pu voir dans le passé c’est que toutes les promesses de la propagande n’arrivent pratiquement jamais. Donc on peut légitimement douter que les voitures autonomes (par exemple) seront dans nos rues aussi rapidement qu’on nous dit et sous la forme que l’on prévoit. À ce niveau-là, ça n’est pas qu’une surprise est toujours possible c’est plutôt qu’une surprise est quasi sûre.

Je peux parfois donner l’impression que je nie le progrès technique… Rien n’est plus faux !

Le problème essentiel vient de la façon dont les nouveautés techniques sont présentées au grand public. A chaque fois, la nouvelle technologie à la mode est accompagnée de promesses pharamineuses à grands coups d’adjectifs ronflants (“révolutionnaire” est le terme le plus souvent utilisé). Mais ça ne veut pas dire que c’est forcément un pétard mouillé pour autant. Internet, par exemple, n’a pas tenu toutes les promesses du temps de la bulle des dotcoms, mais il n’en n’a pas moins changé beaucoup de choses (depuis l’ecommerce qui a redéfinit nos pratiques de consommation jusqu’au cloud qui a redéfinit notre façon de gérer l’informatique). Au final, Internet peut être vu comme une déception seulement si vous avez cru à tous les bobards proclamés dans les années quatre-vingt-dix.

Je sais que la technique finit toujours par progresser, presque inexorablement et ce dans quasiment tous les domaines. Mais j’insiste, cette progression prend simplement plus de temps (toujours plus de temps !) que ce qui en est dit.

La technique ralentit, les retours décroissants sont partout et nous allons droit vers une déception majeure.

L’informatique semble être épargnée par cette stagnation mais c’est une apparence : seuls les capacités progressent (vitesse de traitement, affichage, stockage, taille des appareils et efficience électrique) mais pas les fonctionnalités qui restent très limitées. La meilleure preuve c’est que quand il y a une avancée dans ce domaine (IA avec les images ou la reconnaissance vocale), elle est mise en avant bruyamment !

Le progrès technique devrait être boosté en temps de guerre mais c’est l’inverse qui se produit : les militaires sont conservateurs et la recherche de l’innovation décisive est restée vaine lors des précédents conflits, seule la production de masse compte désormais.

Les programmes militaires sont comme ceux du médicaments : ils ralentissent inexorablement, pour un coût toujours plus élevé et sont donc moins nombreux à aboutir.

Dans le domaine spatiale aussi, les progrès sont très décevants (quasiment une absence de progrès en fait). SpaceX performe simplement en étant plus rationnel que les autres acteurs !

Il y a une grande différence entre un programme étudié et un programme opérationnel. Le nombre de projets étudiés et abandonnés est proprement vertigineux (ils sont très visibles dans les domaines spatial, nucléaire et militaire). Car la dernière marche est toujours la plus dure à gravir. Pour celles et ceux que les lois de l’évolution technique intéressent de plus près, j’ai listé celles-ci dans une série d’articles à voir à https://www.redsen-consulting.com/fr/inspired/tendances-decryptees/les-grands-principes-de-levolution-de-linformatique-introduction. Cela concerne surtout l’informatique (mon sujet de prédilection) mais c’est évidemment transposable et applicable aux autres domaines.

La propagande masque la réalité

La propagande est partout et masque la réalité. Deux exemples pour achever de s’en convaincre. Tout d’abord, un article paru sur “Siècle Digital” intitulé “Nos cellules souches squelettiques pourraient régénérer nos os”.

C’est une avancée scientifique importante qu’une équipe de chercheurs de Stanford vient de rapporter. Ils ont découvert les cellules souches squelettiques qui donnent naissance aux os, au cartilage et à l’os spongieux qui héberge la moelle osseuse. Cette découverte pourrait un jour aider les médecins à réparer ou à remplacer le cartilage des articulations et à guérir plus rapidement les os brisés. https://siecledigital.fr/2018/09/27/cellules-souches-squelettiques-aident-os-regenerer/

Et l’article continue sur le même ton avec des promesses faramineuses comme “Un jour, nous ne nous soucierons plus des effets du vieillissement”. Mais sur les étapes à franchir, les conditions pour confirmer cette découverte et un calendrier d’application, rien. L’annonce est jetée aux yeux du public comme si tout cela ne comptait pas et que cet avenir lumineux était déjà à notre porte !

Ensuite, cet autre article, toujours sur “Siècle Digital” :

Des chercheurs ont réussi à créer par hasard une enzyme capable de détruire du plastique. Une découverte qui pourrait contribuer à résoudre le problème de la pollution liée notamment aux bouteilles en plastiques. https://siecledigital.fr/2018/04/18/enzyme-mange-plastique/

Ce second exemple est encore plus pernicieux que le précédent car, cette fois, on sous-entend qu’on n’a même pas besoin de vraiment chercher des solutions : on va même les découvrir par accident !